Hướng Dẫn Ngăn Chặn Bot AI Quét Dữ Liệu Website

Trong thời gian gần đây, nhiều hệ thống AI sử dụng bot tự động để thu thập dữ liệu từ các website nhằm phục vụ việc huấn luyện mô hình. Điều này có thể khiến nội dung, bài viết hoặc dữ liệu độc quyền trên website của bạn bị khai thác mà không có sự cho phép.

Vì vậy, việc chủ động triển khai các biện pháp ngăn chặn bot AI là rất cần thiết để bảo vệ tài nguyên số, giảm tải máy chủ và hạn chế tình trạng sao chép nội dung trái phép. Bài viết dưới đây sẽ hướng dẫn bạn các cách hiệu quả để chặn bot AI thu thập dữ liệu website, từ phương pháp cơ bản đến nâng cao, áp dụng được cho hầu hết hệ thống website hiện nay.

robots.txt là gì?

robots.txt là một tập tin nằm ở thư mục gốc website, dùng để hướng dẫn các công cụ thu thập dữ liệu (crawler/bot) biết phần nào của website được phép hoặc không được phép truy cập.

Hướng Dẫn Chặn Bot AI Bằng robots.txt

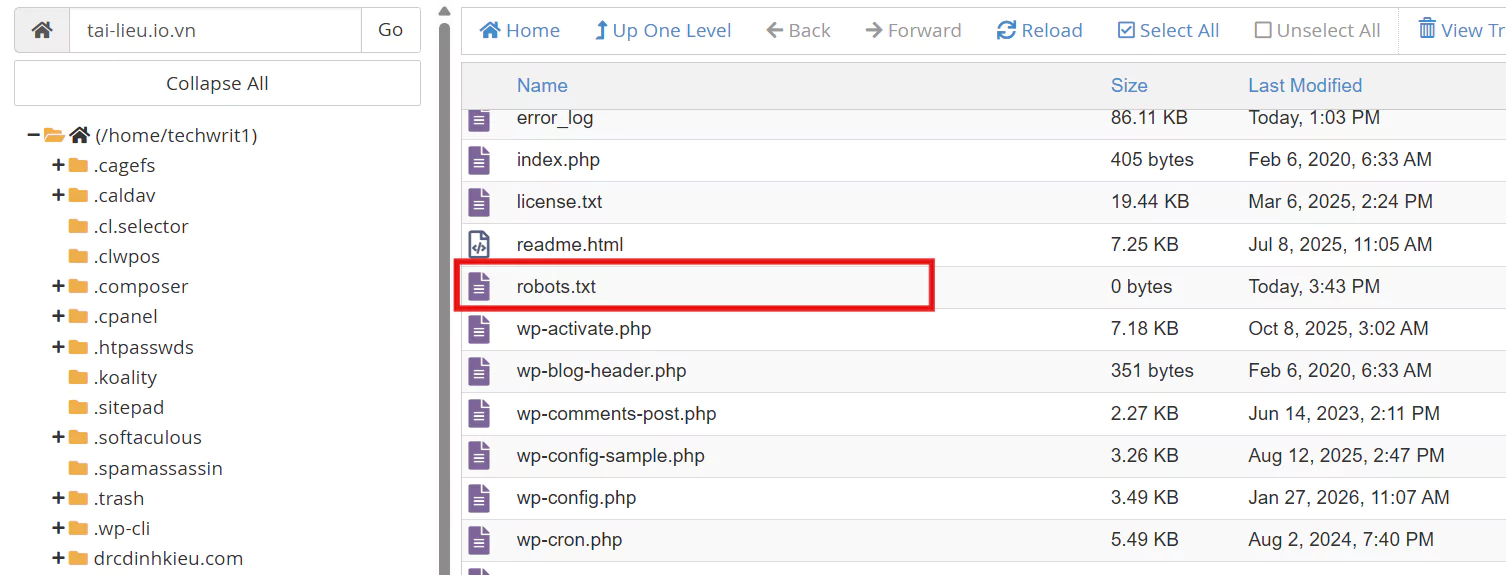

Bước 1: Tạo hoặc mở file robots.txt

-

Truy cập File Manager trong hosting (cPanel, DirectAdmin…)

-

Dùng FTP (FileZilla, WinSCP…)

-

Hoặc SSH vào VPS

File phải đặt tại thư mục gốc website:

Bước 2: Thêm lệnh chặn bot AI

Dán nội dung dưới đây vào file:

vNode Tutorial

User-agent: GPTBot Disallow: / User-agent: ChatGPT-User Disallow: / User-agent: Google-Extended Disallow: / User-agent: CCBot Disallow: / User-agent: anthropic-ai Disallow: / User-agent: ClaudeBot Disallow: / User-agent: Bytespider Disallow: / User-agent: PerplexityBot Disallow: /

Ý nghĩa từng bot trong danh sách:

User-agent: Tên bot (trình thu thập dữ liệu) mà bạn muốn áp dụng quy tắc

Disallow: / Không cho bot truy cập bất kỳ trang nào trên website

GPTBot

Bot do OpenAI sử dụng để thu thập dữ liệu phục vụ huấn luyện AI.

→ Cấu hình này yêu cầu GPTBot không quét website của bạn.

ChatGPT-User

Bot dùng khi hệ thống AI truy cập web để lấy thông tin theo yêu cầu người dùng.

→ Bị chặn hoàn toàn.

Google-Extended

Bot liên quan đến việc Google sử dụng dữ liệu cho các sản phẩm AI (như Gemini).

→ Khác với Googlebot tìm kiếm thông thường. Dòng này chỉ từ chối việc dùng dữ liệu cho AI, không ảnh hưởng SEO.

CCBot

Bot của công ty Common Crawl — nguồn dữ liệu lớn thường được dùng huấn luyện AI.

→ Ngăn nội dung bạn xuất hiện trong các bộ dữ liệu crawl công khai.

anthropic-ai và ClaudeBot

Bot của Anthropic (hãng phát triển AI Claude).

→ Yêu cầu không thu thập dữ liệu từ website.

Bytespider

Bot liên quan đến ByteDance (công ty mẹ TikTok), có hoạt động thu thập dữ liệu web.

→ Bị chặn toàn bộ.

PerplexityBot

Bot của công cụ tìm kiếm AI Perplexity.

→ Ngăn họ dùng nội dung của bạn cho hệ thống trả lời AI.

Tác dụng của cấu hình này

Thể hiện rõ bạn không cho phép các bot AI thu thập dữ liệu

Các công ty AI uy tín thường tôn trọng robots.txt

Không ảnh hưởng đến Google Search nếu bạn không chặn Googlebot

Bước 3: Cho phép bot tìm kiếm bình thường

vNode Tutorial

User-agent: * Allow: / User-agent: GPTBot Disallow: / User-agent: ChatGPT-User Disallow: / User-agent: Google-Extended Disallow: / User-agent: CCBot Disallow: / User-agent: anthropic-ai Disallow: / User-agent: ClaudeBot Disallow: / User-agent: Bytespider Disallow: / User-agent: PerplexityBot Disallow: /

Ý nghĩa từng bot trong danh sách:

User-agent: * (Áp dụng cho tất cả các bot)

Allow: / (Cho phép truy cập toàn bộ website)

→ Điều này đảm bảo các bot tìm kiếm như Googlebot, Bingbot… vẫn index website bình thường, không ảnh hưởng SEO.

| Bot | Thuộc về | Mục đích chính |

|---|---|---|

| GPTBot | OpenAI | Thu thập dữ liệu huấn luyện AI |

| ChatGPT-User | OpenAI | Lấy dữ liệu khi AI truy cập web |

| Google-Extended | Dùng dữ liệu web cho AI (Gemini, Bard…) | |

| CCBot | Common Crawl | Tạo bộ dữ liệu crawl lớn cho AI |

| anthropic-ai | Anthropic | Thu thập dữ liệu cho AI Claude |

| ClaudeBot | Anthropic | Bot AI Claude |

| Bytespider | ByteDance | Thu thập dữ liệu cho hệ thống AI |

| PerplexityBot | Perplexity AI | Dùng nội dung cho công cụ trả lời AI |

Kết luận

Việc sử dụng robots.txt để chặn các bot AI như GPTBot, ClaudeBot, Google-Extended… là bước quan trọng giúp bạn thể hiện rõ ràng rằng website không cho phép thu thập dữ liệu phục vụ huấn luyện AI. Cách này dễ triển khai, không tốn chi phí và không làm ảnh hưởng đến hoạt động index của các công cụ tìm kiếm thông thường nếu cấu hình đúng.

Tuy nhiên, robots.txt chỉ mang tính quy ước tự nguyện, nên để bảo vệ nội dung hiệu quả hơn, bạn nên kết hợp thêm các biện pháp kỹ thuật khác như chặn User-Agent tại máy chủ, dùng tường lửa, giới hạn tốc độ truy cập và các lớp xác thực khi cần thiết.